Algoritma, yapay zeka sistemlerinin 'rakip' girdileri atlatmasına yardımcı oluyor

Mükemmel bir dünyada, gördüğünüz şey, elde ettiğiniz şeydir. Durum bu olsaydı, yapay zeka sistemlerinin işi canlandırıcı bir şekilde basit olurdu. Kendi kendine giden arabalarda çarpışma önleme sistemlerini kullanın.

Yerleşik kameralara görsel girdiye tamamen güvenilebiliyorsa, bir yapay zeka sistemi, kameralarının yolda gördüğü bir yayaya çarpmaktan kaçınmak için bu girdiyi uygun bir eyleme (sağa yönlendirme, sola yönlendirme veya düz devam etme) doğrudan eşleyebilir. .

Peki ya kameralarda bir görüntüyü birkaç piksel kaydıran bir aksaklık varsa? Araba körü körüne sözde "rakip girdilere" güvenirse, gereksiz ve potansiyel olarak tehlikeli eylemler gerçekleştirebilir.

MIT araştırmacıları tarafından geliştirilen yeni bir derin öğrenme algoritması, makinelerin aldıkları ölçümler ve girdiler için sağlıklı bir "şüphecilik" oluşturarak gerçek, kusurlu dünyada gezinmesine yardımcı olmak için tasarlandı.

Ekip, bir takviye-öğrenme algoritmasını derin bir sinir ağıyla birleştirdi; her ikisi de bilgisayarları Go ve satranç gibi video oyunlarında ayrı ayrı eğitmek ve Derin Güçlendirmeli Öğrenme için Sertifikalı Tartışmalı Sağlamlık için CARRL dedikleri bir yaklaşım geliştirmek için kullanıldı.

Araştırmacılar, yaklaşımı simüle edilmiş bir çarpışmadan kaçınma testi ve Pong video oyunu da dahil olmak üzere çeşitli senaryolarda test ettiler ve CARRL'nin, standart makine öğrenimi tekniklerine kıyasla daha iyi performans gösterdiğini (çarpışmalardan kaçınma ve daha fazla Pong oyunu kazanma) buldular. belirsiz, düşmanca girdiler.

MIT'de doktora sonrası araştırma yapan Michael Everett, "Sık sık bir düşmanın bilgisayarınızı hackleyen biri olduğunu düşünürsünüz, ancak aynı zamanda sensörlerinizin harika olmaması veya ölçümlerinizin mükemmel olmaması da olabilir, ki bu da çoğu zaman böyledir," diyor MIT'de doktora sonrası doktoru olan Michael Everett Havacılık ve Uzay Bilimleri Bölümü (AeroAstro). "Yaklaşımımız, bu kusurun hesaba katılmasına ve güvenli bir karar verilmesine yardımcı oluyor. Güvenlik açısından kritik herhangi bir alanda, bu, üzerinde düşünülmesi gereken önemli bir yaklaşımdır."

Everett, IEEE'nin Sinir Ağları ve Öğrenme Sistemleri İşlemleri'ndegörünen yeni yaklaşımı özetleyen bir çalışmanın baş yazarıdır . Çalışma, MIT doktora öğrencisi Björn Lütjens'in yüksek lisans tezinden kaynaklandı ve MIT AeroAstro Profesörü Jonathan How tarafından tavsiye edildi.

Olası gerçekler

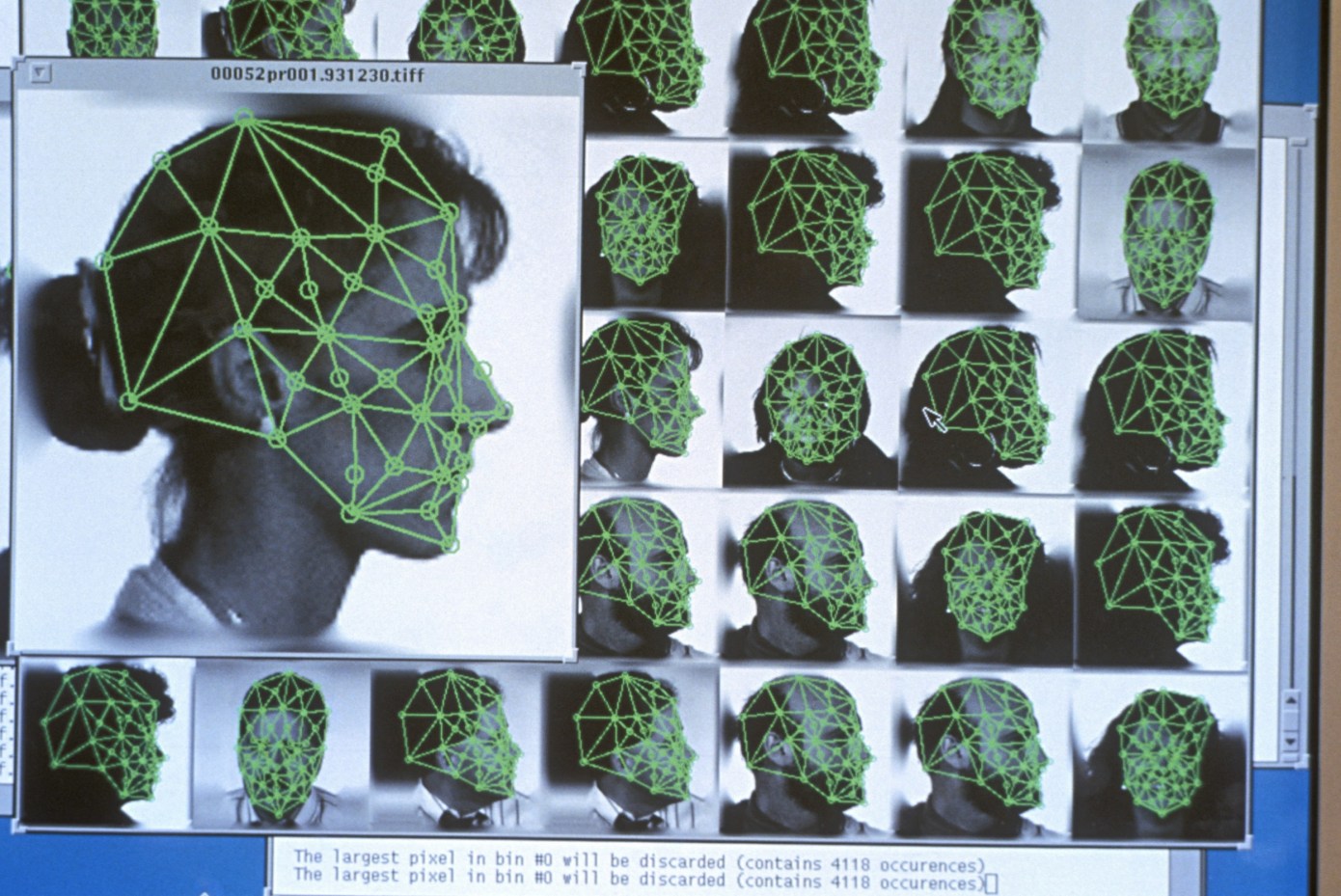

Yapay zeka sistemlerini rakip girdilere karşı sağlam kılmak için araştırmacılar, denetimli öğrenim için savunmalar uygulamayı denediler. Geleneksel olarak, bir sinir ağı, belirli etiketleri veya eylemleri verilen girdilerle ilişkilendirmek için eğitilir. Örneğin, kedi olarak etiketlenmiş binlerce görüntü ile birlikte evler ve sosisli sandviç olarak etiketlenen görüntülerle beslenen bir sinir ağı, yeni bir görüntüyü doğru bir şekilde kedi olarak etiketlemelidir.

Güçlü yapay zeka sistemlerinde, aynı denetimli öğrenme teknikleri, görüntünün çok az değiştirilmiş sürümleriyle test edilebilir. Ağ her görüntü için aynı etikete (kedi) denk gelirse, görüntünün değiştirilmiş veya değiştirilmemiş olması ve ağın herhangi bir muhalif etkiye karşı sağlam olması ihtimali yüksektir.

Ancak olası her görüntü değişikliğinin üzerinden geçmek, hesaplama açısından ayrıntılıdır ve çarpışmadan kaçınma gibi zamana duyarlı görevlere başarıyla uygulanması zordur. Dahası, mevcut yöntemler, ağ daha az sağlamsa ve bazı değiştirilmiş kedi resimlerini bir ev veya sosisli sandviç olarak etiketlerse, hangi etiketin kullanılacağını veya ne yapılması gerektiğini belirlemez.

Lütjens, "Güvenlik açısından kritik senaryolarda sinir ağlarını kullanmak için, bu olası gerçeklerle ilgili en kötü durum varsayımlarına dayanarak gerçek zamanlı kararları nasıl alacağımızı bulmalıydık" diyor Lütjens.

En iyi ödül

Ekip bunun yerine, etiketli girdileri çıktılarla ilişkilendirmeyi gerektirmeyen ancak daha ziyade ortaya çıkan bir ödüle dayalı olarak belirli girdilere yanıt olarak belirli eylemleri güçlendirmeyi amaçlayan başka bir makine öğrenimi biçimi olan pekiştirmeli öğrenmeyi geliştirmeye çalıştı. Bu yaklaşım genellikle bilgisayarları satranç ve Go gibi oyunları oynamak ve kazanmak için eğitmek için kullanılır.

Pekiştirmeli öğrenme çoğunlukla girdilerin doğru olduğu varsayıldığı durumlara uygulanmıştır. Everett ve meslektaşları, pekiştirmeli öğrenmede belirsiz, rakip girdilere "onaylanabilir sağlamlık" getiren ilk kişiler olduklarını söylüyorlar.

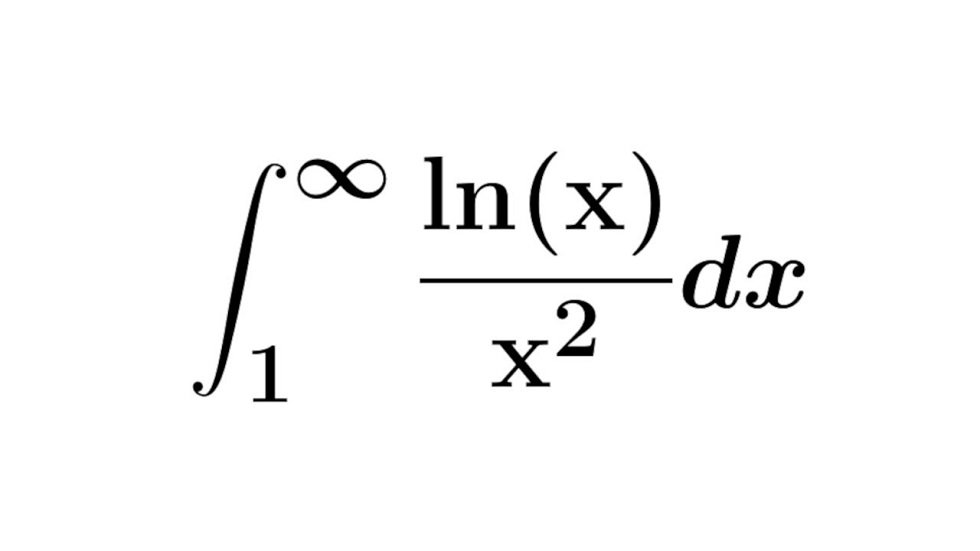

Yaklaşımları CARRL, derin bir Q-ağını eğitmek için mevcut bir derin takviye öğrenme algoritmasını veya DQN'yi (sonuçta bir girdiyi bir Q değeri veya ödül seviyesi ile ilişkilendiren birden çok katmana sahip bir sinir ağı) kullanıyor.

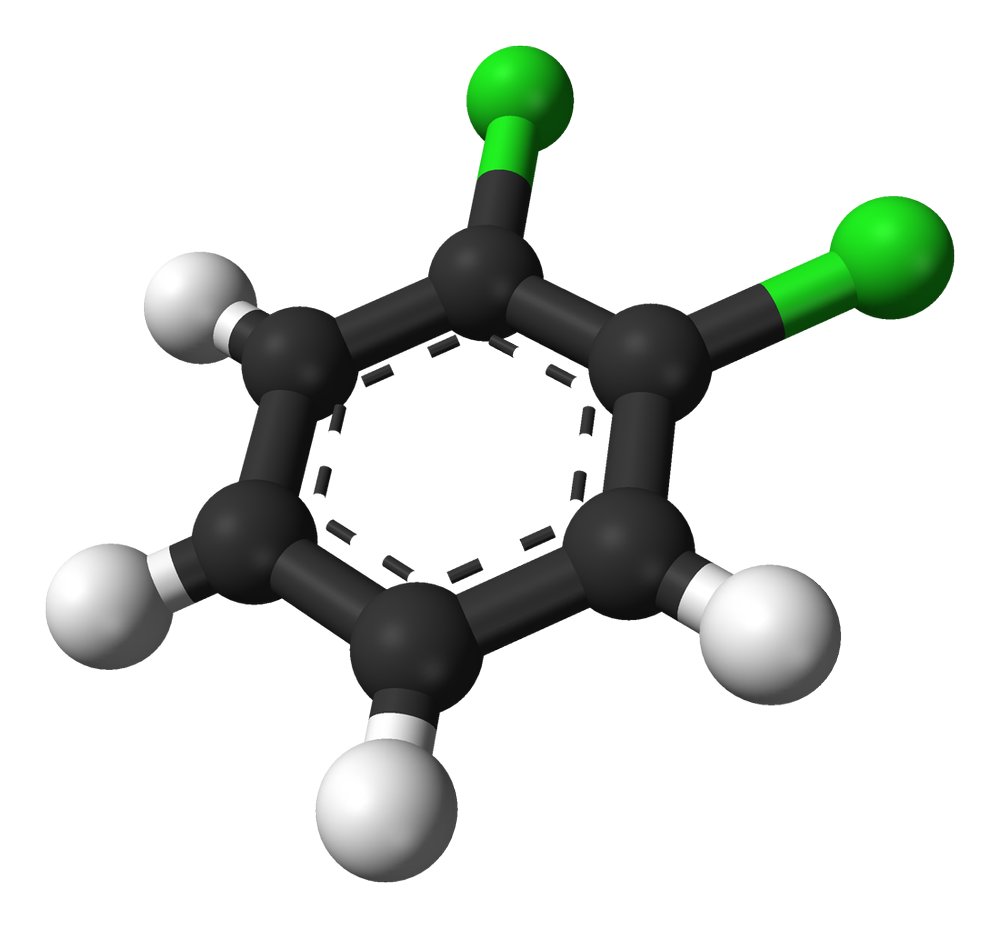

Yaklaşım, tek noktalı bir görüntü gibi bir girdi alır ve düşman bir etkiyi veya bunun yerine gerçekte olabileceği noktanın etrafındaki bir bölgeyi dikkate alır. Bu bölgedeki noktanın olası her konumu, yakın zamanda MIT lisansüstü öğrencisi Tsui-Wei "Lily" Weng PhD 'tarafından geliştirilen bir tekniğe dayanarak, en uygun en kötü durum ödülüyle sonuçlanacak ilişkili bir eylem bulmak için bir DQN aracılığıyla beslenir.

Düşman bir dünya

İki oyuncunun bir topu ileri geri geçirmek için ekranın her iki tarafındaki kürekleri çalıştırdığı video oyunu Pong ile yapılan testlerde, araştırmacılar topu gerçekte olduğundan biraz daha aşağı çeken bir "rakip" ortaya koydular. Düşmanın etkisi arttıkça CARRL'nin standart tekniklerden daha fazla oyun kazandığını buldular.

"Bir ölçüme tam olarak güvenilmemesi gerektiğini bilirsek ve topun belirli bir bölge içinde herhangi bir yerde olabileceğini bilirsek, yaklaşımımız bilgisayara raketi o bölgenin ortasına koyması gerektiğini söyler, böylece topa vurduğumuzdan emin oluruz. En kötü durumda sapmada bile top, "diyor Everett.

Yöntem, ekibin çarpışmadan pozisyon değiştirmeye çalışan mavi ve turuncu bir ajanı simüle ettiği çarpışmadan kaçınma testlerinde de benzer şekilde sağlamdı. Ekip, turuncu ajanın mavi ajanın konumunu gözlemlemesini bozarken, CARRL turuncu ajanı diğer ajanın etrafında yönlendirdi, düşman güçlendikçe daha geniş bir rıhtım aldı ve mavi ajanın konumu daha belirsiz hale geldi.

CARRL'nin çok muhafazakar hale geldiği, turuncu ajanın diğer ajanın çevresinde herhangi bir yerde olabileceğini varsaymasına ve yanıt olarak hedefinden tamamen kaçınmasına neden olan bir nokta geldi. Everett, bu aşırı muhafazakarlığın yararlı olduğunu söylüyor çünkü araştırmacılar daha sonra bunu algoritmanın sağlamlığını ayarlamak için bir sınır olarak kullanabilirler. Örneğin, algoritma, bir temsilcinin hala yüksek bir ödül elde etmesine ve hedefine ulaşmasına izin verecek daha küçük bir sapmayı veya belirsizlik bölgesini dikkate alabilir.

Everett, kusurlu sensörlerin üstesinden gelmenin yanı sıra, CARRL'nin robotların gerçek dünyadaki öngörülemeyen etkileşimleri güvenli bir şekilde ele almalarına yardımcı olmak için bir başlangıç olabileceğini söylüyor.

Everett, "İnsanlar, sensörlerini bloke etmek için bir robotun önüne geçmek veya onlarla etkileşimde bulunmak gibi düşmanca davranabilirler, en iyi niyetle olmayabilir," diyor Everett. "Bir robot, insanların yapmaya çalışabileceği her şeyi nasıl düşünebilir ve onlardan kaçınmaya çalışabilir? Ne tür düşman modellere karşı savunmak istiyoruz? Bu, nasıl yapılacağını düşündüğümüz bir şey."